Towards an Approach for Evaluating the Impact of AI Standards

创建于 更新于

摘要

本报告提出了一个基于“变化理论”(theory of change)的评价框架,旨在系统评估人工智能(AI)标准对促进创新和建立公众信任的影响。通过具体的实体解析用例,报告阐述了评价AI标准的输入、活动、产出、效果和最终目标,并强调了构建反事实对照组的重要性,以实现因果推断。本报告还讨论了利益相关方参与、评价方法选择及持续改进,促进AI标准更有效的制定与应用[page::3][page::10][page::17][page::25][page::28][page::31]

速读内容

研究背景与评价目标 [page::3][page::4]

- AI标准旨在促进创新和公众信任,尤其聚焦数据、绩效与治理规范。

- 当前缺乏系统评价AI标准实际影响的共识方法和衡量指标。

- 报告提出基于已有监测评估框架,设计适合AI标准的影响评价方法。

评价理论框架与方法论基础 [page::10][page::11][page::12][page::13][page::14][page::15]

- 采用“变化理论”(Theory of Change)构建评价逻辑链:输入、活动、产出、效果和目标。

- 强调利用反事实(counterfactual)对比,构建效果度量的基准。

- 反事实构造方法包括前后比较、匹配分析、断点回归和差分法等多种定量技术。

- 利益相关方全程参与设计与实施,保证评价过程透明可信。

- 图示说明评价设计及实施流程,突出外部影响和数据收集前瞻性的重要性。

AI标准评价的结构化流程及实践示范 [page::17][page::18][page::19][page::20][page::21][page::22]

- 理论链被分解为输入(如工作组贡献)、活动(如标准制定)、产出(标准文档发布)、初期效果(例如标准采纳率)与长期目标(创新增长、成本降低、可信AI)。

- 详细举例了实体解析领域中,术语标准化、测试验证和训练数据实践三个关键标准的具体价值与潜在效果。

- 评价指标设计需关注标准推广采纳情况及对相关领域的改进效果。

利益相关方作用与评价方法选择 [page::25][page::26][page::27]

- 强调标准制定者与应用者,以及受影响者的持续迭代参与评价流程。

- 选择适合的混合方法包括案例研究、过程分析及部分因果推断以应对实际复杂性。

- 反事实设计结合具体的使用案例,有助明确标准带来的差异性影响。

结论与未来展望 [page::28][page::31]

- 评价框架有助于持续监测AI标准发展的有效性并服务于标准改进。

- 利用构建的理论变化链,可设计AI标准进度指数,增强透明度和公众信任。

- 实际示范涵盖教育、刑事司法、医疗保健等领域,展示评价在多元场景中的适用性。

深度阅读

金融研究报告详细分析报告

报告元数据与概览

- 报告标题:Towards an Approach for Evaluating the Impact of AI Standards

- 作者:Julia Lane

- 发布机构:纽约大学瓦格纳公共服务研究生院

- 发布日期:2024年11月

- 主题:人工智能(AI)标准的影响评估方法研究

本报告围绕人工智能标准的开发及其对创新和公众信任的促进作用,提出了一套系统化的评估框架和方法。报告核心论点为:目前缺乏一种正式和共享的评价AI标准成效的方法,文中以NSSCET(美政府关键与新兴技术国家标准策略)和NIST AI风险管理框架为指导,提出通过“变革理论”(theory of change)构建评估框架,结合定量和定性指标,科学测量AI标准的开发、采纳及其创新效果和公众信任建设的影响。报告没有给出评级或目标价,而是作为政策制定者、标准制定组织及学术界的讨论基础和方法论参考。[page::0,1,3,4]

---

逐节深度解读

1. 引言(Introduction)

本章指出最近多方呼吁投入AI标准化建设,聚焦AI数据、性能和治理,目标是促进技术创新与公共信任。美国政府的NSSCET和NIST AI风险管理框架提供了指导原则,强调自主、共识驱动及行业领导的标准制定。报告强调AI标准能实现以下功能:统一基础概念与术语、建立风险治理规范、促进系统性能的可比评估;但目前缺乏对标准化活动实际影响的系统评价方法。本文旨在填补这一空白,提出一套可执行的分析方法来评估AI标准的效果和价值。[page::3,4]

---

2. 背景与评估环境(The Context)

对AI标准的评估视为一种政策或项目介入,旨在提高创新和信任。有效评估需对政策背景、操作环境和利益相关者有充分理解,以排除干扰因素,设计出适当的对照组(counterfactual)进行因果关系分析。

- 本节强调构建比较组时避免选择偏差的重要性,因AI标准采纳属于自愿且行业主导,参与方与非参与方往往差异显著。

- 还提及AI行业的标准发展属于后置性策略(trailing edge),标准往往滞后于实际应用,因此前后对比和持续评估极为关键。

- 以“实体解析”(entity resolution,记录去重与链接)作为典型用例,阐明高质量数据整合对AI质量的关键影响。此用例贯穿评估方法论具体举例。[page::5,6,7,8,9]

---

3. 评估框架(Evaluation Framework)

报告提出基于“变革理论”(theory of change)的评估框架,着重描述了框架的三大优势:

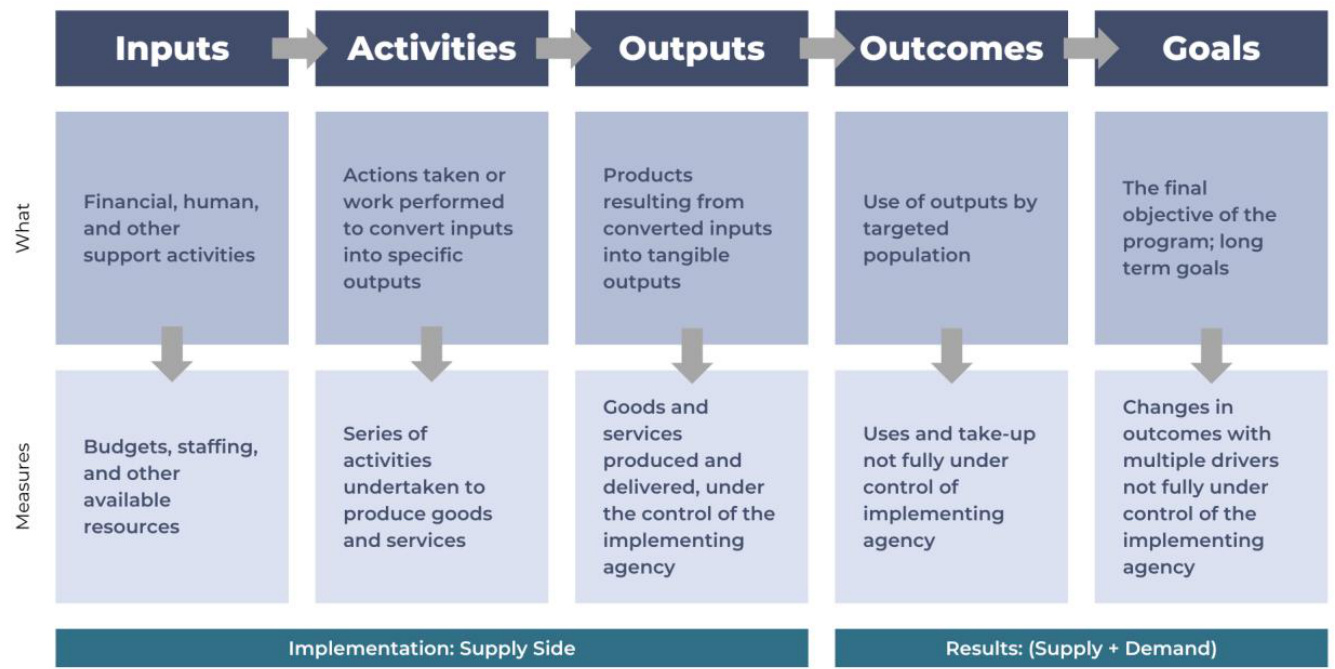

- 明确输入、活动、产出、结果和目标五个环节,使标准制定者和利益相关者清晰理解过程中的因果链。

2. 强调需要设定合理对照组(counterfactual),控制干扰变量,实现因果推断,确保评估的科学性。

- 借鉴社会、行为科学等领域成熟的评估理论,如 Rubin因果模型,确保严谨性和可操作性。

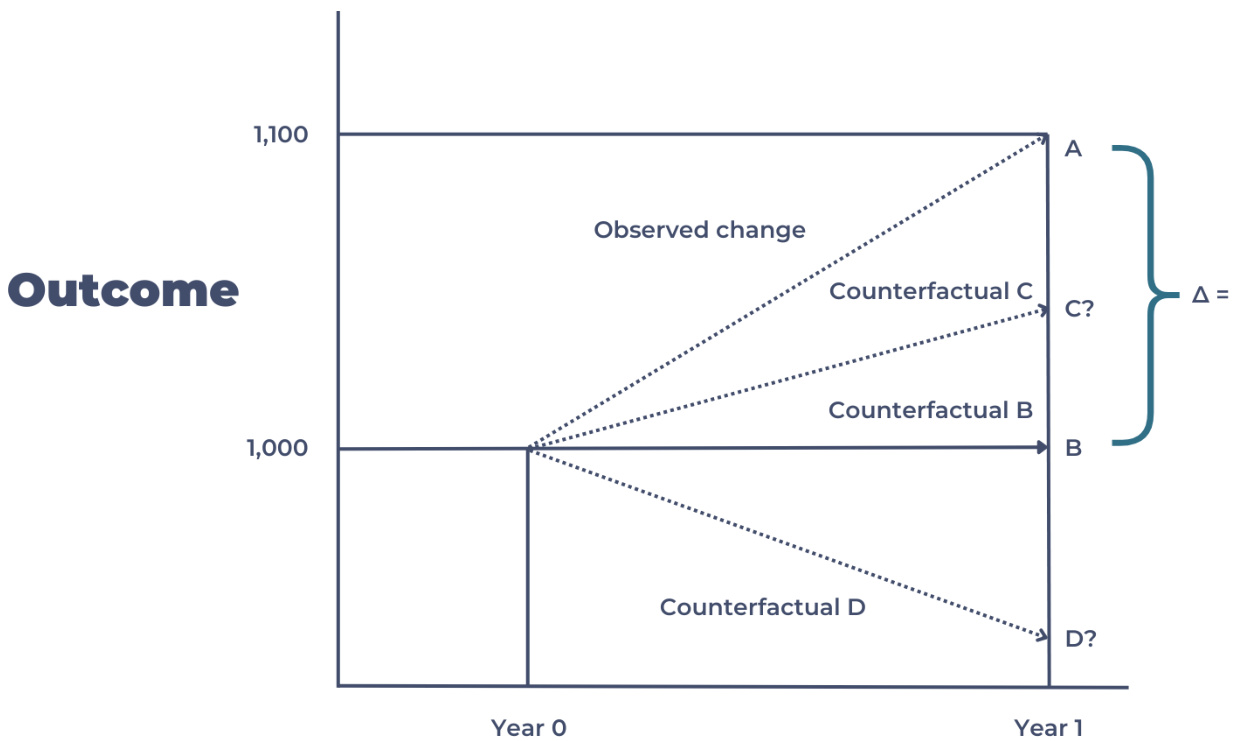

技术细节中,报告通过图表(图1)生动展示了真实案例中观察结果与对照组结果的对比差异,明确评估的“增量效应”(delta)概念:[见图1]。

同时,图2展示了变革理论的逻辑模型,系统划分输入、活动、产出、结果、目标的定义与测量规范,确保不同环节评估具备针对性。[page::10,11,12,13,14]

---

4. AI标准影响评估的应用示例(Assessing the Impact of AI Standards)

本节紧密结合NIST AI 100-5文件阐述AI标准目前的复杂发展态势及不足,如多为概念和治理导向,缺少具体测量和社会影响评估标准。

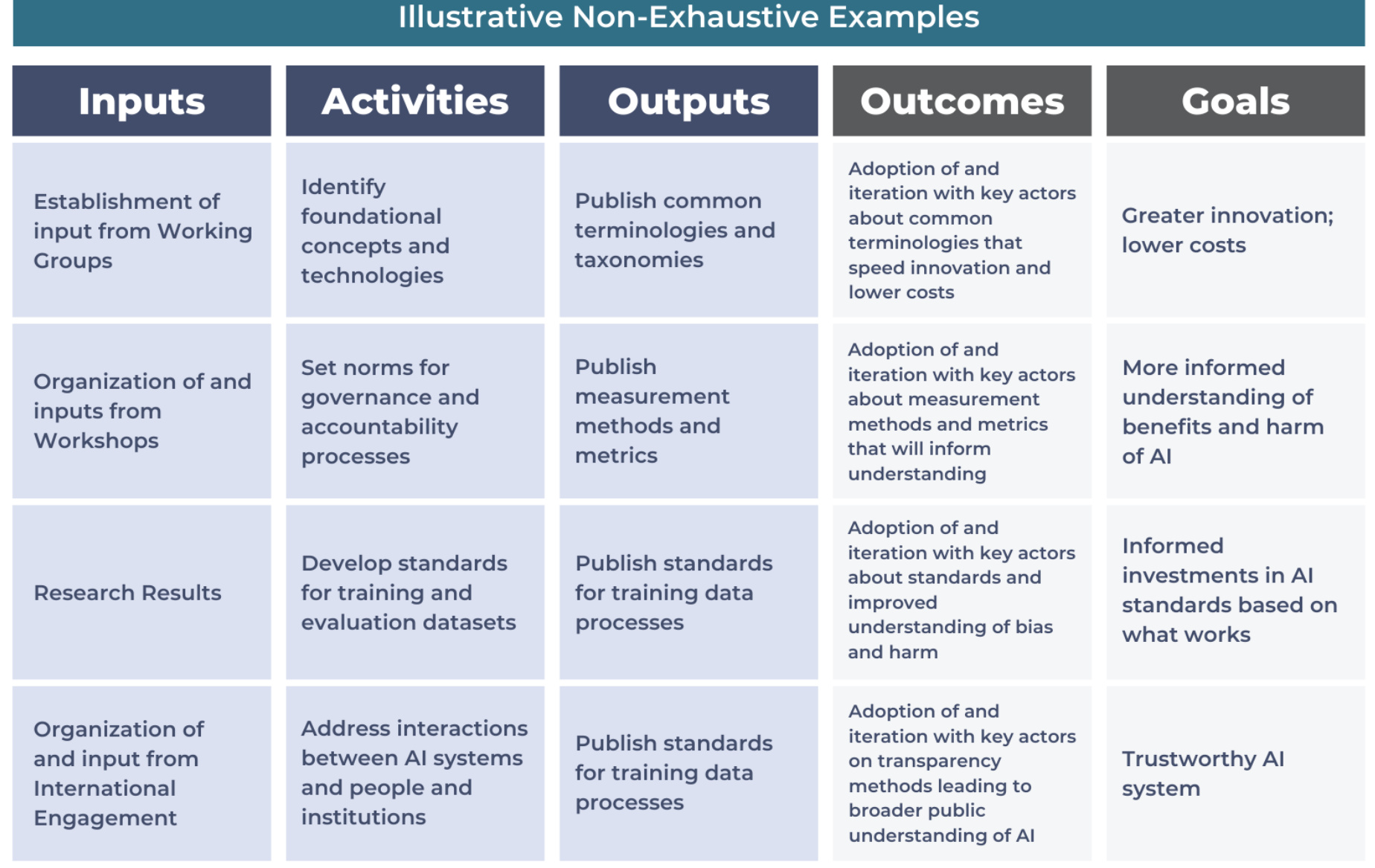

- 图3基于变革理论,详细展示标准制定各环节(输入、活动、产出、结果、目标)如何形成评估路径及关键节点。

- 利用实体解析案例,以三大重点领域为代表展开应用示例:

1. 术语与分类法标准:统一AI领域基础语言,减少沟通误差,促进创新效率。用例中强调了例如基于各组织共享术语,能快速复制和优化模型,节省大量成本。

2. 测试/验证/评估(TEVV)方法与指标标准:通过规范评估AI模型风险及效果,促使AI在医疗健康等高敏领域的安全应用。示例指出统一的评估指标能改善电子健康记录整合质量,保障隐私与准确性。

3. 训练数据管理实践:关注数据质量与偏差管理,特别是对弱势群体的公正影响。标准化的数据预处理和数据偏差测量工具能促使社会服务资源更公平合理分配。

这些用例明确指出每一环节的潜在价值、AI标准贡献及预期成效,强调采纳率是评估中最关键的量化结果指标。同时,长远目标包括加快创新、降低成本及建立可信AI系统。报告强调最终评价应着眼长期,短期关注初步结果监测。[page::16,17,18,19,20,21]

---

5. AI标准有效性评估(Assessing the Effectiveness of AI Standards)

围绕利益相关者的识别与持续参与展开,强调评估活动应与标准制定紧密结合,做到过程透明且易理解。

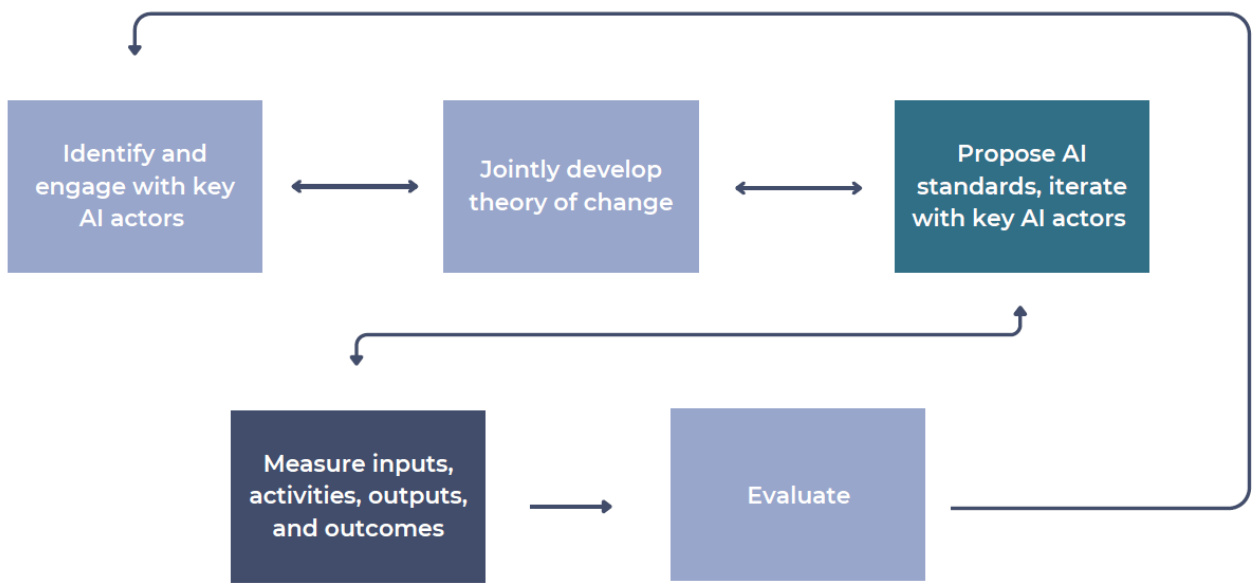

- 采用迭代方式涵盖输入、理论模型制定、标准提案、效果监测、调整反馈等完整循环。

- 评估方法应依托具体标准和使用场景,采用混合方法设计,包括案例分析、过程评估及因果推断。

- 构建对照组的多样性策略被再次强调,具体举例如人工方法与自动化AI方法比较、不同标准采纳群体间差异对比。

- 评估不可避免存在数据不足、样本偏小等局限,但在此基础上仍能有效指导后续标准优化。 [page::25,26,27]

---

6. 总结(Summary)

报告总结指出,建立一套科学严谨的测试和评估体系,对于推动AI标准的优化升级、促进创新生态及公共信任至关重要。

- 理论与实践框架结合变革理论,兼顾输入与产出,形成AI标准指标体系及进度指数。

- 该框架符合NIST AI风险管理框架及美国关键与新兴技术国家标准策略,支持标准化发展透明度与问责制。[page::28]

---

图表深度解读

图1:干预效果与对照组比较示意图(第12页)

- 描述:该图展示了某干预“AI标准”的效果测量,横轴为时间(Year 0到Year1),纵轴为被观察结果指标(Outcome)。点A是干预组年份1的观察结果,点B表示基线年(Year0),点C和D为不同假设的对照组(counterfactual)结果。

- 数据与趋势:该图强调,直接用(A-B)的差值代表效果是不准确的。正确比较是(A-C)或(A-D),依具体对照组变化而定。

- 联系文本:此图形象演示了评估中“因果增量效应”的理念,佐证章节关于counterfactual设计的技术细节。

- 潜在局限:实际中构造对照组存在挑战,如选择偏差或数据不完备,制约因果推断效率。

[page::12]

[page::12]

---

图2:变革理论逻辑模型(第14页)

- 描述:图表以五列展示评估链条:输入(财力、人力等)、活动(具体执行)、产出(直接产品)、结果(用户采用)以及目标(最终影响)。

- 数据与趋势:清晰区分供应与需求侧,强调供给方与需求方的双重关系。逻辑性强,有助量化设计与成效追踪。

- 联系文本:对应对变革理论的详细解释,突出如何结构化设计评估量表和指标。

-

[page::14]

[page::14]---

图3:AI标准的变革理论应用(第17页)

- 描述:本图类似图2,结合具体AI标准开发的输入(工作组、研讨会、研究成果、国际交流)、活动(概念识别、治理规范、标准开发、系统交互)、产出(术语、测量方法、培训数据标准)、结果(采纳和迭代反馈),及终极目标(创新提升、成本降低、信任AI等)。

- 数据与趋势:形象演示了标准开发的“供应链”及其预期效果的全景追踪。

- 联系文本:实证意义上为评估AI标准影响定量化、系统化过程提供蓝图。

-

[page::17]

[page::17]---

图5:利益相关者迭代参与流程(第25页)

- 描述:流程图展示了识别利益相关者、联合设计理论模型、标准提出与迭代、输入输出衡量、评估、反馈循环。

- 数据与趋势:强调持续的、双向互动的利益相关者参与过程,特别适应快速变化的AI领域。

[page::25]

[page::25]

---

估值分析

本报告聚焦于AI标准化影响的评估方法学,未涉及直接的财务估值分析或目标价格设定。其价值体现在为公共政策制定者、标准制定组织及相关企业提供系统、科学的绩效测量工具与反馈机制,辅助指导资源配置和技术迭代。

---

风险因素评估

报告从评估角度指出若干潜在风险:

- 因果关系识别风险:标准发布与创新结果间非必然对应,多标准叠加影响使因果识别复杂。

- 构建有效对照组难度:随机分配不可行,且产业采纳非随机,存在选择偏差。

- 标准生态复杂性:组织多样,标准类型及适用范围差异大,外部有效性不足。

- 数据和度量指标有限:关键数据不足或测量构念(如“信任”)复杂难量化。

- 利益相关者参与不足:无法全覆盖不同角色,影响采纳和评估效果。

报告建议通过系统设计、充分利益相关者参与和多元方法弥补风险,确保评估科学完整。[page::5,6,7,25]

---

批判性视角与细微差别

- 报告基于现有理论与方法论构建的评估框架具有科学性和实用性,但缺少已充分试点和实证应用案例,实际执行中或存在复杂性。

- 由于AI标准迭代快、环境多变,评估结果的稳定性和普适性尚待验证,尤其跨不同产业和地域环境的推广具有挑战。

- 部分假设(如利益相关者持续参与、数据充分获取)理想化,可能低估实际操作中的障碍。

- 文献回顾显示,影响评估数据基础建设目前仍较薄弱,尚需推动相关基础设施和能力建设。

综上,报告提供重要的方法论基础,但需后续深化具体领域和案例的实证研究予以完善。 [page::10,28,34]

---

结论性综合

本报告“Towards an Approach for Evaluating the Impact of AI Standards”系统阐述了AI标准影响的评估必要性和理论方法框架,强调通过变革理论分解输入—活动—产出—结果—目标链条,结合对照组设计,实现科学的因果推断。报告以实体解析为具体案例,详细演示了标准术语、评价指标及训练数据管理等关键领域对创新效率和社会公平的潜在提升价值。报告还就利益相关者参与、评估方法选择及生命周期管理提出明确建议,并辅以丰富图表详解核心流程和技术细节。

图表部分,图1至图3阐释了基于数据比较的增量效应、结构化理论框架及其在AI标准场景的再造过程;图5强调利益相关者的迭代驱动机制。整体呈现出评估体系的严谨性与可实施性。

由于AI标准特点和生态复杂性,评估实践面临因果识别、数据充分性及外部适用性的挑战。报告谨慎指出必须以利益相关者共识和科学的方法论配套,构建动态、持续迭代的标准评估机制,方能保障AI标准推动创新、降低风险及增强公众信任的长远目标。

该框架契合NIST AI风险管理框架和美国NSSCET战略意向,具有高度政策指导意义和行业应用潜力,推荐作为未来AI标准开发和监测的重要方法论参考。[page::0-34]

---

总体而言,本报告为AI标准影响评估提供了系统而详尽的理论方法蓝图,权威而创新,适合标准制定机构、政策制定者及AI系统开发者深入研读应用。